как узнать поддерживает ли видеокарта rtx

Какие видеокарты Nvidia и AMD поддерживают трассировку лучей

Трассировка лучей — одна из самых популярных функций современных видеокарт. Оптимизация технологии трассировки световых лучей обеспечивает более реалистичную картинку, которую можно увидеть в играх с высокими графическими требованиями. Рассказываем о тех видеокартах, которые уже поддерживают эту опцию.

Ввидеокарты Nvidia с функцией трассировки лучей

С момента запуска линейки RTX (Turing) компания Nvidia интегрировала в свою продукцию функцию трассировки лучей. Поэтому существует множество видеокарт, которые поддерживают эту опцию.

Примечание: на некоторых видеокартах Nvidia функция трассировки лучей разблокируется только после установки драйвера Geforce 425.31. Это относится к моделям Titan Xp, Titan X (Pascal), Geforce GTX 1660 Ti, Geforce GTX 1660, Geforce GTX 1080 Ti, Geforce GTX 1080, Geforce GTX 1070 Ti, Geforce GTX 1070 и Geforce GTX 1060 6GB.

Видеокарты AMD с трассировкой лучей

В то время как Nvidia уже некоторое время оснащает свои видеокарты функцией трассировки лучей, пользователям AMD придется набраться терпения. Графические процессоры AMD, поддерживающие эту технологию, еще только появляются.

Только новейшие видеокарты AMD серии RX 6000 будут поддерживать трассировку лучей. К ним относятся AMD Radeon RX 6800, AMD RADEON RX 6800 XT и AMD RADEON RX 6900 XT. Серия RX 6800 поступила в продажу в ноябре 2020 года, RX 6900 — в декабре 2020 года.

Что такое Nvidia RTX, как технология трассировки лучей меняет графику в играх и зачем покупать новую GeForce (коротко и с примерами)

Что такое Nvidia RTX?

Nvidia RTX — платформа, содержащая ряд полезных инструментов для разработчиков, которые открывают доступ к новому уровню компьютерной графики. Nvidia RTX доступна только для нового поколения видеокарт Nvidia GeForce RTX, построенного на архитектуре Turing. Основная особенность платформы — наличие возможности трассировки лучей в реальном времени (также называемой рейтресингом).

Что за трассировка лучей?

Трассировка лучей — функция, которая позволяет имитировать поведение света, создавая правдоподобное освещение. Сейчас в играх лучи двигаются не в реальном времени, из-за чего картинка, зачастую, хоть и выглядит красиво, но всё равно недостаточно реалистична — используемые сейчас технологии требовали бы огромное количество ресурсов для рейтресинга.

Это исправляет новая серия видеокарт Nvidia GeForce RTX, обладающая достаточной мощностью для расчёта пути лучей.

Как это работает?

Это побудило Nvidia внедрить дополнительные ядра в видеокарты GeForce RTX, которые возьмут на себя большую часть нагрузки, улучшая производительность. Они также снабжены искусственным интеллектом, задача которого — высчитывать возможные ошибки во время процесса трассировки, что поможет их избежать заранее. Это, как заявляют разработчики, также повысит скорость работы.

И как трассировка лучей влияет на качество?

Shadow of the Tomb Raider, релиз которой состоится 14 сентября этого года:

Battlefield 5, которая выйдет 19 октября:

Metro Exodus, чей выход намечен на 19 февраля 2019 года:

Control, дата выхода которой пока неизвестна:

Вместе с этим всем, Nvidia рассказала, какие ещё игры получат функцию трассировки лучей.

Как включить RTX?

А есть ли аналоги у AMD?

Технология, которая будет работать на API Vulkan, пока находится в разработке.

Видеокарта NVIDIA GeForce RTX 4080 может выйти в 2022 году и будет в 2 раза быстрее GeForce RTX 3080

Как мы вчера могли убедиться, видеокарты дорожают не только в отечественных магазинах, но даже в Китае. У этого явления есть несколько причин. В первую очередь сильнейшее давление на полупроводники оказывают майнеры, а ведь графические чипы не перестали закупать центры обработки данных и крупные компании, занимающиеся облачными вычислениями. Мало того, переход на удалённую работу привёл к возросшей потребности в компьютерах, а многие люди получили несколько лишних часов на развлечения. Обычно, это время тратилось на поездку на работу, а сейчас достаточно встать с дивана и подойти к рабочему столу. На самом деле проблем много, но результат один: повышение цен на все компоненты и дефицит полупроводниковой продукции.

реклама

10 месяцев назад стартовали продажи линейки видеокарт NVIDIA GeForce RTX 3000. На дворе 9 сентября, а большинство даже не видело ни одну из карточек в магазинах. Если судить по ценам и доступности графических чипов, то не увидим ещё много месяцев. Прогнозировать завершение дефицита сегодня не берётся никто, поэтому текущее поколение останется актуальным очень долго. И вот здесь и кроется главная проблема: инженеры NVIDIA не могут ждать, ведь разработка новых архитектур не останавливается ни на миг. Обычно, новое поколение видеокарт появляется в продаже раз в два года, поэтому перенос следующего поколения может нарушить всю цепочку разработок. Как заявляют инсайдеры, графические чипы GeForce RTX 4000-й серии стоит ждать к концу 2022 года.

Если текущая серия получила кодовое наименование архитектуры Ampere, то следующая будет называться Ada Lovelace. Выпуск графических чипов доверят TSMC, а сами они будут создаваться на 5-нм технологическом процессе. Сообщается о невероятном количество ядер CUDA в количестве 18 432 на GPU AD102. Если сравнивать это с текущим GA102, то чистый прирост окажется равен 71%. Инсайдеры уверяют, что нас ждёт двухкратный рост производительности, что уже не кажется фантастическим, ведь кроме роста ядер есть ещё и архитектурные улучшения, а также продвинутый 5-нм техпроцесс. Всё это должно позволить совершить ещё один прорыв, укрепив положение NVIDIA.

Кстати, на эти же сроки назначен выход видеокарт AMD RDNA 3. Красные также претендуют на 5-нм техпроцесс TSMC и не планируют сдавать рынок зелёным. Ждать ценовой войны не стоит, ведь полупроводниковый кризис никуда не делся, но это не значит, что анонс не вызовет интереса у энтузиастов, геймеров, и, конечно же, майнеров.

Способы определения видеокарт Nvidia Geforce RTX 30 с ограничителем майнинга LHR

1 Способ. По названию.

Все видеокарты RTX 3090 не имеют ограничений в майнинге.

Видеокарта RTX 3060 имеет два вида блокировки программную, которую уже взломали, и LHR. Маркировка LHR для этой видеокарты так же не указывается, т.к. эти видеокарты изначально выпускались с блокировкой майнинга.

Видеокарты Nvidia RTX 3070 Ti и RTX 3080 Ti все с ограничителем майнинга LHR, даже если это и не указано в названии и на коробке с видеокартой.

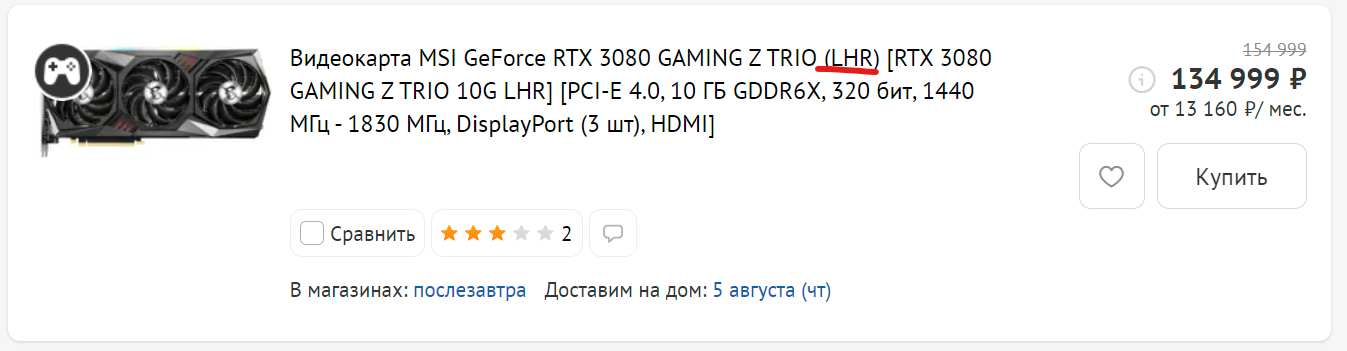

Для видеокарт RTX 3060Ti, RTX 3070 и RTX 3080 производитель может указать на коробке или в названии о принадлежности продаваемой видеокарты к новой ревизии, в которой реализованна технология Lite Hash Rate (LHR). В этом случае сразу понятно, что в майнинге такие видеокарты будут показывать заниженный хешрейт.

Если в названии модели нет указаний, что это LHR модель, то к сожалению, это не означает, что это старая ревизия без ограничений в майнинге. Это может быть как LHR так и обычная видеокарта.

По каким причинам производители вводят покупателей в заблуждение: намеренно или нет. Остается только догадываться.

Если Вам попалась видеокарта без обозначения LHR, то для проверки такой видеокарты на ограничение в майнинге воспользуетесь другими способами.

2 Способ. По GPU ID

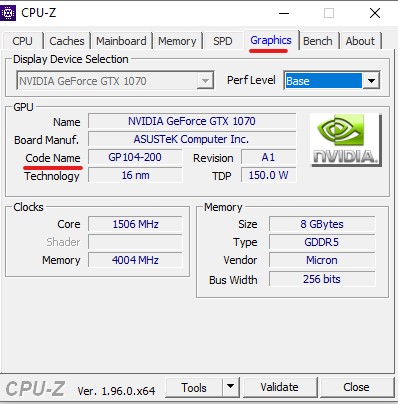

Это самый надежный способ проверки на наличие LHR в видеокарте компании Nvidia, но для этого необходимо проверяемую видеокарту установить в компьютер и запустить программу СPU-Z или аналогичную в которой есть возможность узнать GPU ID видеокарты.

Понятно, что при покупке видеокарты под заказ или в интернет магазине такой возможности у Вас точне не будет, поэтому такой способ больше подойдет при покупке видеокарт на вторичном рынке или в местном магазине у которого можно вернуть товар в первые дни после покупки.

Все GPU ID видеокарт Nvidia RTX 3000

| Видеокарта | GPU ID | LHR | Подробнеее |

| RTX 3060 | GA106-300 | — | Программный LHR |

| GA106-302 | LHR | ||

| RTX 3060 Ti | GA104-200 | — | |

| GA104-202 | LHR | ||

| RTX 3070 | GA104-300 | — | |

| GA104-302 | LHR | ||

| RTX 3070 Ti | GA104-400 | LHR | |

| RTX 3080 | GA102-200 | — | |

| GA102-202 | LHR | ||

| RTX 3080 Ti | GA102-225 | LHR | |

| RTX 3090 | GA102-300 | — |

3 Способ. По обозначению модели

Все видеокарты в зависимости от модели и производителя имеют свой уникальный номер или код продукта. У каждой компании в этом отношении свои правила по обозначению различных моделей видеокарт и их исполнения.

Эти обозначения всегда можно посмотреть на коробке от видеокарты или на самой видеокарте, так же обозначение кода продукта часто указывается на сайтах компьютерных магазинов.

С выходом LHR модификаций все производители выпустили новые ревизии видеокарт, что отразилось в их обозначении:

ASUS — отмечает LHR версии видеокарт индексом V2

Gigabyte — маркирует LHR видеокарты как Rev. 2.0

MSI, Zotac— пишут просто и понятно LHR

Palit, Gainward — маркирует LHR видеокарты суффиксом V1

EVGA — код модели LHR заканчивается буквами KL

4 Способ. По дате выпуска (серийному номеру)

Кроме обозначения модели у каждой видеокарты есть серийный номер, по которому можно определить дату выпуска данной видеокарты. Обозначение даты выпуска для каждого производителя в серийном номере так же отличается и не имеет единой системы. Поэтому для каждого производителя рассмотрим обозначение дат в серийных номерах отдельно.

Определение даты выпуска видеокарт Nvidia по серийному номеру

Серийный номер компании ASUS: M2 N0CX00Y276001

Серийный номер компании Gigabyte: SN 2125 41020415

где 2125 это 21 год и 25 неделя. Поэтому с большой вероятностью это видеокарта будет с LHR.

Серийный номер компании Palit: B O20 0154221

Серийный номер компании MSI: 602-V389-143SB 2106 000014

где 2106 это 21 год 6 месяц

Для видеокарт Zotac, EVGA, KFA2 и Inno3D мы не нашли информации как определить по серийному номеру дату производства. Если у Вас есть такая информация, то поделитесь ею с нами в телеграм чате Cryptoage.

5 Способ. По маркировке GPU чипа.

Узнать GPU ID видеочипа можно так же разобрав видеокарту и удалив термопасту с чипа, где будет гравировка с GPU ID. В этом способе нет необходимости, т.к. GPU ID можно узнать с помощью программы CPU-Z, тем более что при разборке видеокарты теряется гарантия и вернуть такую видеокарту в магазин по гарантии уже не получится.

Дата производства видеокарты после 22 недели 2021 года, т.е. после мая 2021 года, не означает что все видеокарты выпущенные после этой даты имеют ограничение майнинга LHR, т.к. у производителей еще остались запасы старых GPU чипов, которые они постепенно используют в производстве. Соответственно, чем позже выпуск видеокарты, тем меньше шансов купить видеокарту Nvidia без ограничетеля в майнинге.

Подпишись на наш Telegram канал @cryptoage и Вконтакте, узнавай новости про криптовалюты первым.

Общайся с криптоэнтузиастами и майнерами в Telegram чате @CryptoChat

RTX-OFF / RTX-ON или включаем возможность использования трассировки лучей на старых видеокартах

Оглавление

Вступление

В данной статье будут рассмотрены вопросы и технические нюансы возможности использования видеокарт, не поддерживающих трассировку лучей на аппаратном уровне, с играми, графика которых построена на новой технологии.

реклама

Но перед тем как углубиться в технические детали, следует вспомнить, что же такое: свет, луч, преломление света и собственно технология компании Nvidia, которая реализует эти физические процессы в трехмерной графике посредством своего нового GPU серии TU102 и других, принадлежащих к архитектуре «Turing».

Если кто-то не в курсе, то новая графическая архитектура «Turing» названа в честь английского математика, логика и криптографа Алана Тьюринга. Она совершила революцию в трехмерной графике и помимо всем привычных потоковых мультипроцессоров добавила в структуру GPU новые RT-ядра.

В самом мощном ускорителе новой линейки – GeForce RTX 2080 Ti – насчитывается 68 RT ядер, а в самом младшем, GeForce RTX 2060, всего 30. На первый взгляд их количество не столь велико, но далее мы выясним, что за ними скрываются большие возможности.

Уроки физики

Вначале обратимся к школьной программе. С седьмого класса на уроках физики начинают изучать оптические явления и понятие электромагнитного излучения, воспринимаемое человеческим глазом (или попросту – свет). Раздел физики, в котором содержится свет, называется «Оптика».

А в одиннадцатом классе изучается закон преломления света, распространение лучей в различных средах, коэффициенты преломления сред, оптические искажения и прочее.

Думаю, все помнят опыты, когда высчитываются углы преломления в призме. Нет? Если честно я и сам подзабыл этот раздел, чего не скажешь об инженерах Nvidia, которые со времен GeForce256 изучают этот раздел науки и с каждым поколением графических ускорителей обещают нам кинематографическую графику.

реклама

Итак, луч – это исходящий от источника излучения поток фотонов, обладающий определенной энергией и нулевой массой. Понятие «Свет» сводится к электромагнитному излучению, воспринимаемому человеческим глазом.

Но в графических процессорах с поддержкой RTX эти явления представляются совсем иначе или более упрощенно, поскольку никакого излучения там нет по определению. Луч моделируется в виде вектора, а вектор, напомню из курса геометрии восьмого класса – это направленный отрезок.

У луча есть три основных характеристики, определяющие его свойства. Первое – точка начала луча, второе – точка преломления луча, третье – точка соприкосновения луча с видимой поверхностью.

Получается, чтобы GPU просчитал алгоритм построения графического 3D образа, необходимо выполнить расчеты с тремя инструкциями, данные которых будут содержать точные координаты в трехмерном пространстве. Этим и занимаются все RT-ядра с эффективной производительностью – три операции с лучом за один такт.

Другие GPU также могут выполнять различные физико-математические расчеты, но для этого им потребуется уже как минимум три операции, из-за чего скорость отрисовки трехмерной сцены будет низкой. В лучшем случае мы увидим слайд-шоу, поэтому производитель GPU не выпускает драйверы для ранее вышедших игровых видеокарт.

На самом деле трассировка лучей на старых видеокартах возможна уже сейчас (!), начиная с принадлежащей к архитектуре «Tesla» линейки GPU G80. Ее первым представителем была GeForce 8800 GTX, вышедшая на рынок в далеком 2006-м году.

Сначала GeForce 8800 GTX, а вслед за ним и самый мощный графический ускоритель, построенный на базе GPU G80 – GeForce 8800 Ultra (к слову, последняя «Ультра») – стали поддерживать технологию NVIDIA CUDA (англ. Compute Unified Device Architecture) или программирования общего назначения первого поколения.

Обе видеокарты Tesla оперировали 128-ю скалярными (а не как ранее векторными) блоками ALU с плавающей точкой, способными выполнять любые программируемые операции.

Впечатляющая производительность данного блока достигалась за счет работы ALU на удвоенной частоте GPU (для GeForce 8800 GTX это 1.35 ГГц).

По сути, новая серия графических ускорителей представляла собой небольшой микропроцессор со 128-ю ядрами, каждое из которых в свою очередь оснащалось своим кэшем и исполняло любые поставленные задачи. Главное – определиться, что и CUDA вычислять и отправлять.

реклама

Подготовка

А теперь переходим к тому, как это может быть реализовано на практике. Выше уже отмечалось, что трассировка лучей включает три стадии или координаты, изменяемые во времени.

Вначале просчитывается отправная точка луча, затем идет расчет угла отражения и в конце операции следует расчет координаты отрисовки пикселя на экране монитора пользователя.

Первые две стадии нашему глазу не видны, видеокарта отрисовывает результат лишь третьей стадии, иначе бы для полной картины отрисовки всего механизма не хватило бы и пары GeForce RTX 2080 Ti, трудящихся над поставленной задачей в реальном времени.

реклама

Формула RTX в реал-тайм режиме проста: Три стадии + три точки координат = три видеокарты. Все верно, для того чтобы не наблюдать слайд-шоу, необходимо, как минимум три GeForce 8800 GTX, а лучше Ultra!

За один временной такт каждая видеокарта будет делать свой участок работы. Первая возьмет вычисление отправной точки луча, вторая рассчитает его преломление, третья подсчитает итоговые координаты.

Как видите, далеко не каждая система, даже чисто физически, сможет это реализовать на практике. Во-первых, нужна соответствующая материнская плата, явно не бюджетного или среднего сегментов, и такие же видеокарты, поддерживающие технологию 3-Way SLI.

реклама

Но поддержка таких мультиграфических конфигураций как раз и появилась с восьмой серией 3D ускорителей GeForce GTX.

Существует одна непроверенная легенда, что драйверы с поддержкой трассировки лучей могли быть выпущены давно, но проблема заключалась в операционной системе Windows. Компания Microsoft еще не была готова внедрить в существующий API данную технологию, и лишь с выпуском Microsoft Windows 10 Creators Update такая возможность наконец-то появилась, но мало кто о ней знает.

Если посетить сайт NVIDIA и зайти в раздел «Drivers», можно увидеть, что для видеокарт восьмого поколения доступен сертифицированный Microsoft WHQL драйвер версии 342.01, размером 292.47 Мбайт для операционной системы Windows 10 64-bit edition. Но нам потребуется следующая бета-версия драйвера за номером 342.02 Beta, объемом 468.72 Мбайт. Я не случайно указываю размер файла, так как лишние 176.25 Мбайт строк кода как раз и привносят RTX составляющую.

реклама

Данную версию драйверов найти непросто, ее постоянно удаляют по требованию создателя, но она порой встречается на китайских форумах, поэтому ищите ее, переводя название файла на упрощенный китайский, и обязательно смотрите на итоговый объем файла, поскольку можно скачать что угодно, включая набор троянов. Я же по этическим соображениям активные ссылки на закачку давать тут не буду.

Есть и еще один нюанс, но он не связан ни с видеокартами Nvidia, ни с ядрами CUDA. От центрального процессора, который будет заниматься обработкой данных, получаемых от драйвера видеокарт, зависит общая итоговая производительность всей системы при использовании трассировки лучей по вышеописанной схеме.

Использование процессора, поддерживающего AVX инструкции хотя бы первого поколения, будет неоспоримым плюсом. Именно векторные инструкции в режиме реального времени помогут лучам трассироваться в таком же режиме на поверхность с дополнительной прибавкой производительности, доходящей порой до дополнительных трех процентов к общему результату.

Если же ваш процессор поддерживает AVX инструкции второй версии, то прибавка может достигать уже пяти процентов. А при использовании AVX-512 и вовсе приблизится к дополнительным 10% производительности в 3D.

реклама

Реализация

В качестве тестовой системы в моем случае будет выступать следующая конфигурация:

За предоставленную материнскую плату ASUS Striker Extreme выражаю благодарность mentoza, наконец-то и она пригодилась 🙂 А с ее обзором можно ознакомиться по ссылке. В качестве операционной системы использовалась Microsoft Windows 10 Creators Update, 64-bit edition с последними обновлениями на март 2019 года.

реклама

Результаты тестов

На данный момент список игр, поддерживающих технологию построения изображения посредством трассировки лучей (RTX), не слишком большой, хотя с момента анонса 20-й серии NVIDIA прошло уже полгода. За основу были взяты Battlefield V и Metro Exodus, как идеальный вариант для демонстрации возможностей эксперимента. В остальных играх будет наблюдаться аналогичная тенденция.

Для сравнения я добавил результаты тестов настоящих конкурентов в виде GeForce RTX 2080 Ti, GeForce RTX 2070 и GeForce RTX 2060. Что из всего этого получилось, можно увидеть на графике ниже.

Battlefield V, (Роттердам)

1080p, High, RTX – On

Средний результат, FPS

Включите JavaScript, чтобы видеть графики

Вот это поворот событий! Три видеокарты GeForce 8800 Ultra в режиме RTX выдают в Battlefield V фреймрейт на уровне или даже чуть выше, чем у самой младшей модели из семейства RTX – GeForce RTX 2060!

Понятное дело, что в разрешении 4К будет полный провал, несмотря на работу трех GPU, из-за банальной нехватки доступной видеопамяти, но ведь никто не мешает взять пару GeForce следующих поколений.

Metro Exodus, (Весна)

1080p, High, RTX – On

Средний результат, FPS

Включите JavaScript, чтобы видеть графики

В более «свежей» игре Metro Exodus троица GeForce 8800 Ultra всего на два кадра в секунду уступила новой GeForce RTX 2060, но это также очень достойный результат!

Данная технология использования старых видеокарт, несмотря на свои плюсы, все же затратная со стороны используемых ресурсов, поэтому если у вас есть четыре одинаковых видеокарты, поддерживающие технологию Quad-SLI, можете смело установить их все вместе.

Не забываем, что GPU в некоторых играх рассчитывает еще и физику. Ранее, до появления видеокарт поколения «Tesla» (G80), этими расчетами занимался дискретный ускоритель Ageia Physics, права на который вместе с самой компанией выкупила Nvidia (и позже добавила блок физических расчетов во все последующие GPU).

В самом идеальном варианте построения псевдо-RTX системы будет установлено семь видеокарт. Трудозатраты шести уйдут на трассировку лучей, а седьмая будет заниматься их координацией, прочими физическими расчетами, а также выводом картинки на экран.

Но тут возникает финансовый вопрос, стоит ли игра свеч? Ответ – да, если у вас есть майнинговая ферма для продажи и там установлено несколько видеокарт. Тогда, при наличии на руках семи GeForce GTX 980 Ti, от которых сейчас избавляются разоряющиеся владельцы крипто-ферм, можно получить систему, превосходящую пару GeForce RTX 2080 Ti по производительности на 30-40%.

Дочитав до этого момента, вы убедились, что обладая устаревшими видеокартами и необходимой материнской платой, а также потратив время на поиски нужного драйвера, еще рано списывать со счетов былых флагманов, и нет никакой надобности бежать в магазин за видеокартами серии RTX. Все довольно комфортно может выглядеть и на GPU с поддержкой CUDA.

Все мы говорим о трассировке лучей. Лучи, свет…, но мало кто догадывается об обратной стороне этого вопроса или «Луне», где света никогда и не было, а есть лишь «Тьма». Я подразумеваю темную, неосвещенную сторону Луны, и это сравнение приводится для наглядного примера.

Темнота, тьма. Говоря о тьме, я предполагаю лишь один из возможных вариантов развития событий в игровой индустрии. Предположим, в скором времени AMD добавит трассировку лучей в свои видеокарты, затем начнется гонка вооружений между производителями за количество RT-ядер и в конечном итоге может получиться так, что будущие GPU всех игроков рынка будут состоять сплошь и рядом из одних RT ядер, лишившись прочих исполнительных блоков.

С одной стороны, это хорошо, яркие солнечные пейзажи в разрешении 8К и выше будут с легкостью отрисовываться на ура. Даже планеты, похожие на мир из кинофильма «Аватар», где не одно солнце освещало поверхность планеты, а несколько, не создадут особой нагрузки на миллионы RT ядер.

С другой стороны, мы можем лишиться игр класса «Horror» или тех ужастиков, где действия происходят под покровом ночи. Почему? Нет источника света – нет трассировки лучей, нечему преломляться и нечему отражаться.

И в скором времени вы забудете, что значит ходить с лишь одним фонариком, который является одним источником света, и убивать монстров, как например в старом добром Doom III.

Вы лишитесь и ночных гонок, таких как в Need for Speed: Underground, лишитесь и права войти в закрытую комнату, где спрятан очередной секрет (но в ней нет источника света, поскольку NextGen RTX GPU, основанный только на RT ядрах, будет не в силах отрисовать тьму.

Все игры будут похожи на прогулки Супер Марио в яркий солнечный день с наложенными десятью HDR фильтрами. Вот и скажите, готовы ли вы обменять Свет на Тьму?

Но это лишь один из возможных вариантов развития событий. И чтобы не случилось страшного, поделитесь ссылкой на данную статью со всеми своими друзьями и знакомыми… И, возможно, когда наступит день Х, кто-то из них вспомнит, что все могло бы быть иначе…, и когда-то об этом рассказывалось на Overclockers.ru.

Будущее RTX технологий

Надеюсь, краски не сильно сгущены? Может быть, кто-то сразу решил избавиться от своей видеокарты RTX? Не волнуйтесь, я с радостью готов ее принять, все же иногда даже трех GeForce 8800 Ultra бывает недостаточно.

Но в конце мне бы хотелось остановиться на позитивной ноте и кратко рассказать о будущем RTX технологий. В реальной жизни существует много физических явлений, и пока ни один настоящий RTX не в силах кинематографично передать реальную картинку на экран монитора, сколько бы нам этого не обещали.

К примеру, в природе в неоднородно нагретом воздухе лучи света распространяются не прямолинейно, а плавно искривляясь. Вследствие этого возникают миражи, когда посреди жгучей пустыни путешественнику впереди мерещится озеро, которое отражает голубое небо.

Или, думаю, все видели летом мираж, когда в жаркий летний день водителю или пассажиру автомобиля кажется, что он видит лужи на сухом раскаленном асфальте. Это явление происходит из-за разности температур слоев окружающего воздуха и особенностей преломления лучей.

Увы, пока технология миражей (условно назовем ее MTX) недоступна, но в ближайшем будущем и она будет реализована силами NextGEN GPU 300-й серии (осень 2019). Это относится и к северному сиянию, радуге и прочим природным явлениям.

Но после выхода новой серии видеокарт я вернусь к вопросу изучения их характеристик и возможности отрисовки миражей и других физических явлений на видеокартах, не поддерживающих новую технологию трассировки лучей сквозь неоднородные среды.

Заключение

В сети достаточно давно гуляют шутки, связанные с технологией Ray tracing. И не сосчитать, сколько было выпущено карикатур, демотиваторов и мемов о «RTX-ON, RTX-OFF».

Но после прочтения нашей статьи вы, конечно же, сделаете правильные выводы и примете эту технологию такой, как есть. А что будет в будущем – посмотрим, да и какой будет 3D графика – тоже вскорости узнаем.