как узнать количество скачиваний с гугл диска

Как отследить скачивание файлов в Dropbox и Google Drive

Вы предоставили доступ к важному файлу в Dropbox или Google Drive. И что происходит потом? Вы начинаете ждать ответа от человека, которому предназначен файл. Посмотрел ли он файл, а может, он вообще даже не скачивал его. Избавиться от всех сомнений помогло бы отслеживание скачивания файлов и их прочтения. И вот как это можно сделать.

Orangedox — сервис, который занимается отслеживанием взаимодействий со всеми общедоступными файлами в вашем аккаунте Dropbox и Google Drive.

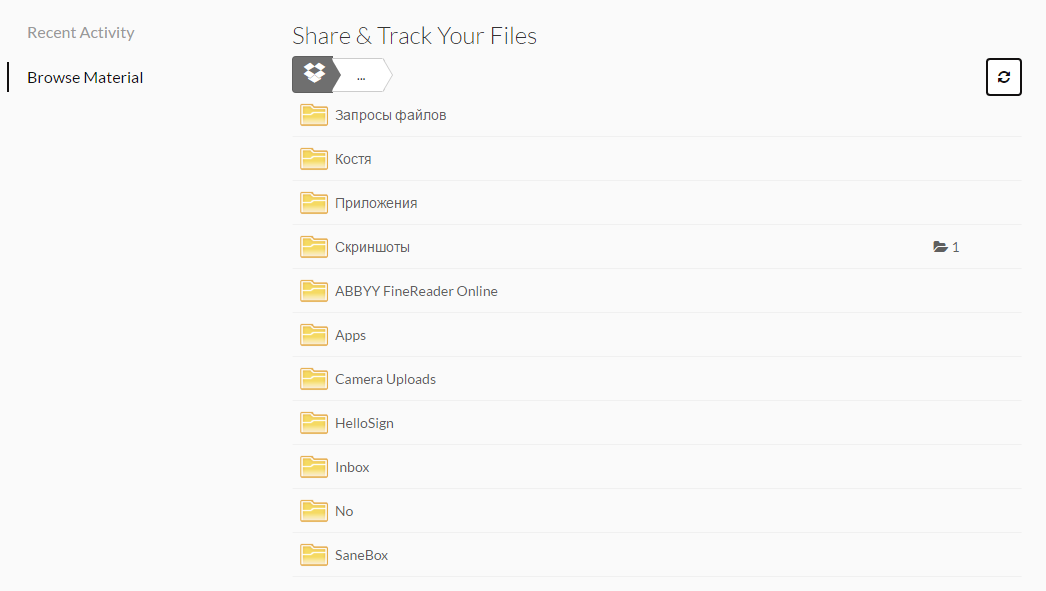

Для начала работы с сервисом нужно подключить свои аккаунты облачных хранилищ, после чего они станут доступны прямо в Orangedox.

Просмотр файлов в Orangedox

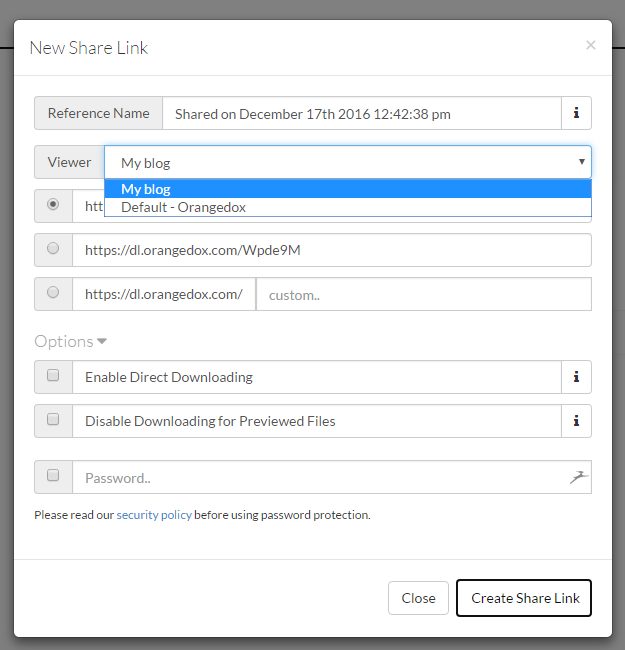

Выберите нужный файл или папку и нажмите «Share». В появившемся окне вы сможете задать удобное для восприятия имя ссылки, выбрать просмотрщик файла (об этом ниже), выбрать вид ссылки. Кроме этого, можно ограничить доступ по паролю или запретить скачивание файла.

Настройки ссылки для скачивания

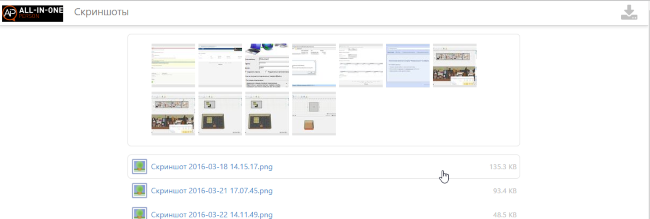

Создайте ссылку и поделитесь ей с получателем. Платные пользователи сервиса могут создать брендированный просмотрщик файлов или использовать стандартный. В любом случае посетитель ссылки увидит все предоставленные ему файлы.

Сразу же Orangedox принимается за отслеживание ссылок и файлов. Был ли клик по ссылке, были ли скачаны файлы. Владельцам PDF-файлов сервис поможет узнать, на какой конкретно странице был закрыт документ. Вся статистика доступна к просмотру на странице аккаунта либо можно настроить получение отчётов на e-mail.

Как узнать количество скачиваний с гугл диска

Запускаем видеорекламу в YouTube. В 1,8 раз больше лидов за 4 месяца

Google обновил Lighthouse до версии 8.3.0

Можно ли с помощью Google Analytics отслеживать сколько раз был скачан файл/архив с сайта?

Если Да, то как именно?

сделать страничку с авто-запуском скачивания через яваскрипт. не лучший конечно метод и не самый точный.

Можно, отслеживая действия по кликам на ссылке, которая ведет на закачку файла, (для нового кода ga.js):

А также учёт не сработает, если посетитель нажмёт на ссылку правой кнопкой и выберет «Save as».

Спасибо всем за информацию.

ActionTime:

Т.е. мне нужно вставить этот код в ссылку, которая ведет на скачивание файла на странице?

Где потом смотреть статистики по нему?

Derinie:

Спасибо всем за информацию.

Небольшое уточнение:

Т.е. мне нужно вставить этот код в ссылку, которая ведет на скачивание файла на странице?

Где потом смотреть статистики по нему?

Предположим есть файл filename, фактический путь к нему path, и можно указать «виртуальный путь» (для отслеживания в GA) files

так может выглядеть код страници

И установить соответствующие цели, если это требуется

Кейс: Как отслеживать скачивания файлов и программ на сайте с помощью Google Analytics Статьи редакции

Артур Кузяков, генеральный директор компании DriverPack Solution, поделился с редакторами рубрики Growth Hacks нестандартным подходом к получению и анализу статистики скачиваний файлов и программ на сайте.

Для улучшения нашего сервиса ( drp.su) мы отслеживаем с помощью Google Analytics и «Яндекс.Метрики» конверсию пользователей в воронках следующего типа.

Это стандартная задача для веб- и мобильного аналитиков, но мало кто работает с переходами от загрузки программы на сайте к её запуску на компьютере. Это связано с тем, что в цикле использования закачка файла или программы всего одна и потери там небольшие, или с тем, что на других уровнях воронки проблемы гораздо больше.

Самое очевидное решение — проанализировать логи Nginx. Для этого можно было бы использовать такие инструменты, как AWstat, GoAccess, ELK stack или Splunk, или в крайнем случае собирать логи где-то у себя. В использовании каждого из перечисленных инструментов есть свои минусы: неудобный интерфейс, скудность получаемых данных, сложность настройки, необходимость «допиливать» и так далее, то есть все вышеперечисленные решения по тем или иным причинам не подходят.

Помимо несоответствия существующих решений выставляемым требованиям, мало ответить на вопросы, кто, когда, как часто и сколько скачивает драйверов. Эти данные надо объединить с данными, которые хранятся в Google Analytics. Только тогда можно будет увидеть полную картину, построив сегменты пользователей, воронки и отчёты.

Вот тогда мы и решили заставить веб-сервер Nginx отправлять события в Google Analytics сразу после завершения скачивания файла. Бонусом добавили в событие завершения закачки отправку IP, время начала скачивания, количество переданных байт и даже Google ClientID.

Сделав интеграцию Nginx и Google Analytics мы получили возможность анализировать скачивания статичных файлов, к которым раньше невозможно было привязать счётчик Google Analytics.

Информация по загрузкам статических файлов на наших Download-серверах приходит в Google Analytics в режиме «реального времени».

Заработало

Теперь можно отслеживать, сколько происходит реальных скачиваний нашего продукта. Причём подсчёт уникальных загрузок производится в разы точнее, чем если делать это по IP-адресу, так как к каждому пользователю привязан уникальный идентификатор — ClientID.

Ошибки 404 и 500 также отслеживаются через события ( events) в Google Analytics.

Благодаря тому, что мы передаём в событии реальный IP-адрес пользователя, можно увидеть распределение скачиваний по гео.

Так как пробрасывается реальный Google Analytics ClientID пользователя, можно верить отчётам о:

Nginx сам передаёт правильный User-Agent, что даёт возможность построить отчёты по браузерам и ОС. В отчёте можно встретить wget, которым наш DriverPack Online выкачивает драйверы, реальные браузеры, а также роботов и парсеров.

Для кого-то окажется очень ценной информация о загрузках с мобильных устройств.

К большому сожалению, передать в Google Analytics Referrer мы пока не можем, так как Nginx не поддерживает urlencode(). В связи с этим отчёты по каналам работать не будут (подробности в разделе «Недостатки»).

Что это нам дало, и что это может дать вам

Отправляя Nginx-логи в Google Analytics, мы смогли добавить новый уровень в воронку использования продукта.

Новый уровень позволил оценить потерю пользователей, связанную с такими факторами, как обрывы закачек, незапуск приложения после успешного скачивания (например, если приложение качается дольше приемлемого времени и пользователь про него забывает), медленное скачивание или большой размер приложения.

При этом возможность пробрасывать Google Analytics ClientID позволяет связать события из Nginx со всеми данными в Google Analytics: версия браузера, время дня, география, демография аудитории и даже кастомные события.

Мы успешно используем все эти сведения для того, чтобы увеличить количество запусков. Например, увеличив скорость доставки контента в отдельные регионы, мы смогли снизить потерю пользователей между вторым и четвёртым уровнем более чем в два раза.

Бонусным эффектом от внедрения модуля стал отлов возникающих ошибок 404, что позволило оперативно реагировать на их появление и повысить качество предоставляемой услуги. По приблизительным оценкам, оперативная работа с 404 ошибками снизила потери пользователей в месяц на 40 тысяч.

Повторные скачивания в рамках одной сессии также свидетельствуют о проблемах, например, об обрыве загрузки или о том, что пользователь не нашёл скачанное приложение.

Наш модуль даёт возможность перенести данные о проблемах с загрузкой файлов в знакомый и мощный инструмент аналитики (Google Analytics). Это позволяет работать в воронке использования продукта с новым уровнем, который обычно пропускают.

Все онлайн-проекты, в которых требуется скачивать продукт с сайта или файлы в мобильном приложении, могут извлечь большую выгоду из применения нашего решения, точечно работая с конверсией из нажатия на кнопку «Скачать» в открытие скачанного файла.

Как вы используете открывшиеся возможности, решать вам. Будем рады получить ваши варианты применения и предложения по улучшению.

Ложка дёгтя

Скрипт работает отлично и на 100% соответствует нашим требованиям, но в него можно добавить несколько улучшений.

Do it yourself

1. Создаём отдельно счётчик Google Analytics, с которым будут работать все Download-серверы. Или используем номер существующего счётчика.

2. В настройках счётчика «Пользовательские параметры» добавляем специальные параметры:

Это поможет нам рассчитать скорость закачки и даже процент оборванных скачиваний.

3. Создаём конфиг с названием google-analytics в директории /etc/nginx/.

4. Получаем конфигурационный файл /etc/nginx/conf.d/default.config.

5. Перезапускаем Nginx.

6. Настраиваем счётчик на сайте таким образом, чтобы ClientID сохранялся в Cookie.

7. Теперь в Google Analytics можно увидеть данные о скачиваниях, обращениях к URL, HTTP-статусы и прочее. Всё это связывается со всеми остальными данными в Google Analytics по ClientID.

Напоследок о точности

Точность статистики до 99%. Мы проанализировали несколько файлов и сравнили данные Google Analytics с данными из логов.

Сравнение показывает, что Google Analytics подсчитывает уникальные загрузки ещё точнее, чем мы можем сделать это вручную.

Присылайте собственные кейсы, в результате которых вам удалось заметно улучшить (или, наоборот, ухудшить) показатели проекта. Интересные эксперименты обязательно попадут на страницы рубрики Growth Hacks.

Загружаем и храним в Google Drive файлы любого размера бесплатно. Баг или Фича?

Недавно я нашел странную особенность в Google Drive. Определенная последовательность действий в Google Drive веб интерфейсе приводит к тому, что каждый может загрузить файлы любого объема в свою учетную запись и при этом не потратить ни одного байта на их хранение.

Конечно, я сразу решил сообщить об этом в Google через программу BugHunter. Но, к моему сожалению, потратив неделю на общение со специалистами Google мне так и не удалось убедить их, что это баг. Сотрудник не смог воспроизвести этот баг и я получил ответ, что «это не баг, а фича» и меня отправили в RTFM. В конце концов Google просто закрыл тикет и перестал отвечать на мои письма.

Так как переписка с Google зашла в тупик, я решил публично рассказать о этой «фиче» и, возможно, наконец привлечь внимание сотрудников Google к этой проблеме или хотя-бы понять, что я делаю не так. Ниже под катом история переписки с Google и proof of concept.

Вот отчет, который я отправил в Google.

Summary: Service abuse: Free unlimited file storage, space counting error

Steps to reproduce:

Any regular user can do that with google drive user interface or experienced user via google drive api. A user can upload unlimited amount of files without any payments and store files forever for free.

Как ясно из текста, чтобы воспроизвести проблему, необходимо создать новую учетную запись. После чего перейти в google drive и найти файл «Getting started», который создается автоматически в каждом новом аккаунте.

Первое, что мне сразу бросилось в глаза, что размер этого файла 1MB, но занимает он 0 байт.

Это было странно, так как PDF это не нативный формат хранения Google Drive и должен использовать общий лимит. Было понятно, что сервис каким-то образом исключает этот файл из списка на подсчет места. Простое копирование файла приводило к тому, что файл начинал весить реальный мегабайт.

Однако, как оказалось, если вместо копирования файла просто загружать новую версию, то эта новая версия все равно будет занимать 0 байт.

Перед тем как опубликовать эту статью, я повторил эксперимент с новой учетной записью и без всяких проблем успешно загрузил 17GB в аккаунт с лимитом 15GB.

В Google Drive можно выбрать опцию «сохранять все версии», я проверил, если ее выбрать, то все версии файла сохраняются и не тратят лимит места.

Таким образом, путем нехитрых ухищрений можно хранить сколько угодно файлов любого размера в Google Drive.

К сожалению, сотрудник Google не смог воспроизвести эту проблему и попросил меня сделать видео:

We’re closing this bug, as you didn’t provide enough details for us to determine what the security issue you’re reporting. Feel free to update this report with additional details.

We tried to replicate it and wasn’t able to, if you think you were able to feel free to share a proof of concept in a video.

If you didn’t provide this yet, please include the reproduction steps (https://sites.google.com/site/bughunteruniversity/improve/help-us-reproduce-the-bug), an attack scenario (https://sites.google.com/site/bughunteruniversity/improve/writing-the-perfect-attack-scenario) and a short explanation why do you believe this is a technical security vulnerability.

Я сделал видео со своего тестового аккаунта в моем домене Google Apps с лимитом 15GB.

И через некоторое время получил вот такой ответ:

Thanks for the POC, we noticed in the video you shared it is associated with Gsuite account visible on the right top of the video screen.

For more information on G suite storage limit please visit. support.google.com/a/answer/172541?hl=en

Your report is now *closed*

Thanks!

Google Trust & Safety

Дальнейшие мои попытки связаться с Google не увенчались успехом, я попробовал написать еще один комментарий, приложил еще раз видео с POC с обычного акаунта, но в ответ только тишина.

В заключение, хочу сказать, что я достаточно много участвовал в Yandex BugBounty и всегда получал отличную обратную связь по всем моим отправленным отчетам. К сожалению, в Google, на мой взгляд, очень странно относятся к таким сообщениям. Скорее всего, это моя первая и последняя попытка отправить информацию о баге в приложениях Google при такой обратной связи.

P.S. Ссылка на report, если на Хабре вдруг присутствуют сотрудники Google, возможно они смогут прояснить, что я сделал не так.

UPDATE 26.02.2020:

Сегодня баг переоткрыли. Всем спасибо!

Быстрая загрузка большого количества данных в Google Colab

Доброго времени суток, Хабр. Решил поделиться своим знанием, как можно быстро загрузить большое количество файлов в Google Colab с Google Drive.

Всем известно, что Google Colab отличная бесплатная платформа для обучения и экспериментов над Нейронными Сетями.

На платформе Google Colab Вам бесплатно предоставят мощную видеокарту на которой вы сможете поэкспериментировать с обучением своей нейросети на протяжении примерно 12 часов.

Затем сеанс прервется, но на следующий день от Google можно опять будет получить видеокарту и продолжить свои эксперименты.

Нейронным сетям требуется очень много данных для обучения, особенно если речь идет о нейросетях работающих с изображениями.

Для обучения таких нейросетей необходимо загрузить в обучающую и валидационную выборки тысячи и сотни изображений. К сожалению, если эти изображения загружать непосредственно из вашего Google Drive, это занимает неприлично долгое время — десятки минут или даже часы. Ведь каждое обращение за файлом в Google Drive и получение от него ответа с содержимым файла происходит последовательно и не быстро.

Обидно тратить время доступа к бесплатной видеокарте на загрузку данных, да и не разумно это.

А мы люди разумные, поэтому мы один раз обратимся к Google Drive считаем наши данные запакованные заранее в zip архив, распакуем полученный zip архив в память Google Colab и считаем свои данные со скоростью в сотни раз большей чем с Google Drive последовательно по одному файлу.

Для эксперимента со скорость загрузки данных в Colab я взял имеющуюся у меня базу «Airplanes» для сегментационной нейросети.

В этой базе есть папка с изображениями «самолеты» и папка «сегментация», где хранятся маски изображений самолетов из вышеназванной папки.

В каждой папке по 1005 изображений 1920*1080.

В общей сложности нам предстоит загрузить 2010 файлов.

Я заранее загрузил к себе на Google Drive как саму базу с изображениями, так и ее zip архив.

Структура Обучающей Базы:

Итак, приступим к скоростной загрузке данных с Google Drive:

Как видно, время за которое мы загрузили 2010 файлов c размером изображения 1920*1080 составило всего 0,96 сек.

То есть, менее чем за секунду, мы загрузили весь наш объем информации.

Как мы видим для загрузки из каталога 2010 файлов хранящихся на Google Drive нам потребовалось уже 1500 секунд, а ведь это 25 минут.

Это 25 минут простоя вашего экспериментов с нейросетью.

Надеюсь, статья была для вас полезной и теперь загрузка большого количества файлов с Google Drive в Colab больше уже не проблема.

Загружайте свои обучающие данные в сотни раз быстрее чем делали до этого ранее.

Всего четыре простых шага.

Для тех, кому нужен код, описанный в статье, добро пожаловать ко мне на GitHub.